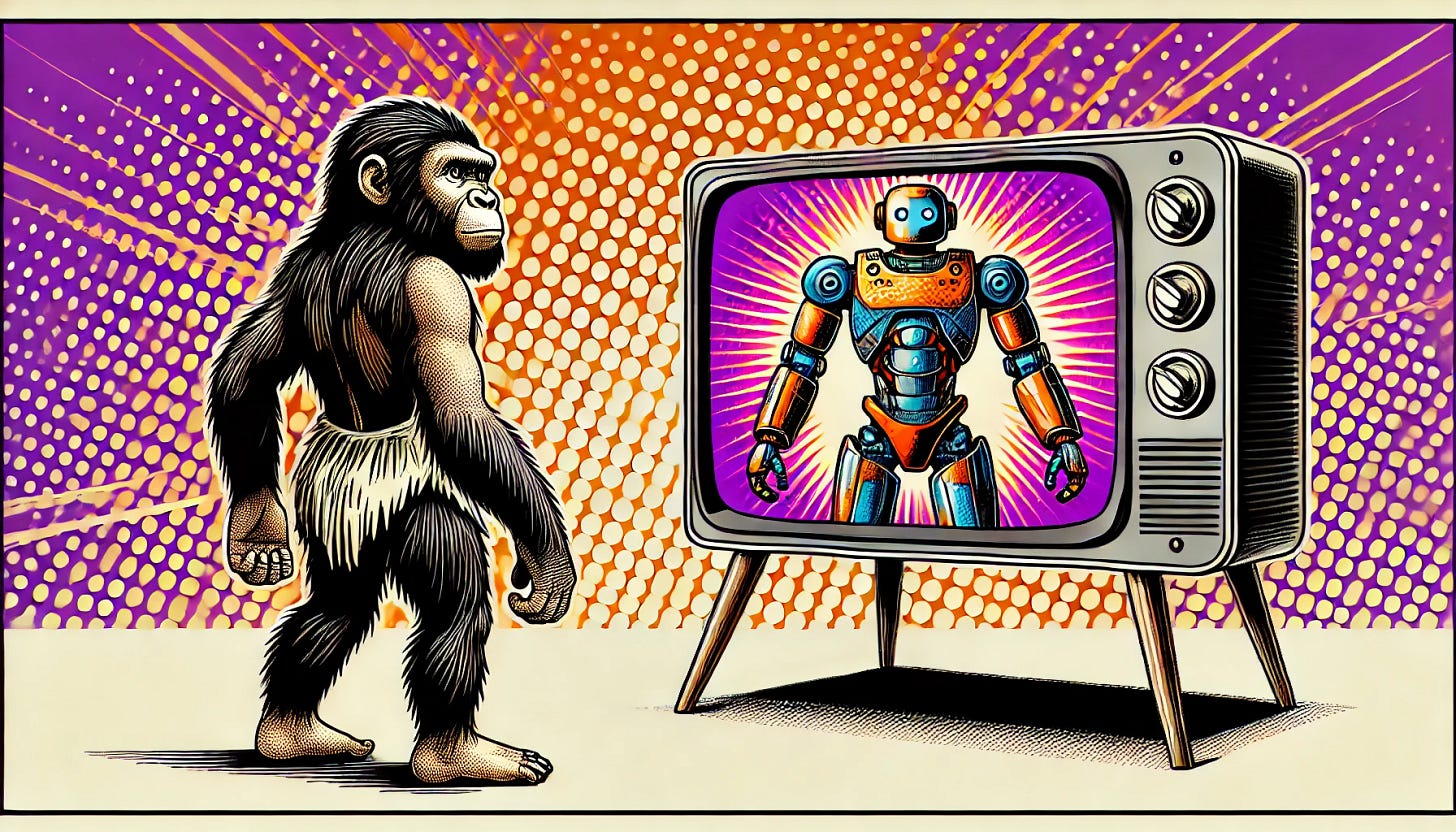

LLMs 是AGI 演化路径上的尼安德特人还是智人?

在圣诞节前的 OpenAI 发布会上,O3 模型的推出引起了广泛关注,其科学推理能力和 AGI 进展表现引人注目。然而,随之而来的一些问题,如高昂的测试成本和无法解决的基础问题,重新引发了关于 LLMs 是否具备理解能力的讨论。尽管规模定律面临瓶颈,后训练阶段依然存在提升空间,LLMs 是否能成为通向 AGI 的关键或仅是误入歧途,仍然是一个值得深思的问题。

圣诞前OpenAI发布的O3模型:AGI前沿的突破与挑战

在圣诞节前,OpenAI 举行了连续 12 天的线上发布会,最终在最后一天推出了备受瞩目的 O3 模型。发布会上,O3的Demo展示了惊人的科学推理能力,并且基准测试结果表明,这一进展将大规模语言模型(LLMs)向通用人工智能(AGI)迈进了一大步。

然而,随着发布会的结束,一些未曾提及的信息逐渐浮出水面,引发了更多的讨论和质疑。例如,在最受关注的 ARC-AGI 测试中,O3 的高性能版本回答问题的成本高达3200美元,这一数据让人不禁对其实际应用产生疑问。

更令人关注的是,O3 未能解答的某些问题,例如以下这个看似简单的题目:

题目:“一个彩色方块拼图,其中通过在单个蓝色方块之间画线并将交叉的矩形区域变成蓝色,显然可以得出正确解法。”

从人类角度来看,这个问题并不复杂,但 O3 却未能给出正确的解答。这个结果再次证明了,尽管 LLMs 在表面上能够进行复杂的推理和回答,但它们本质上并没有“理解”能力,所做的仅仅是根据概率进行计算。

此外,OpenAI 之前推出的文生视频应用 Sora,也在测试中暴露出类似的问题。在生成的真实视频中,Sora 显示出许多物理细节不协调的现象,进一步表明其对物理世界的理解仍然严重不足。

这些现象和问题引发了关于 scaling law(规模定律)是否仍然有效的广泛讨论。越来越多的声音认为,规模定律已经失效,且 LLM 的发展似乎进入了瓶颈期。

Scaling Law的瓶颈:预训练停滞,后训练仍有潜力

我个人的看法是,规模定律确实面临瓶颈,AGI 的发展在 预训练(pre-training) 阶段似乎已经接近极限。随着模型参数的增多,性能的提升趋于缓慢,成本却在迅速上升。然而,这并不意味着 LLM 的潜力已被完全耗尽。相反,在 后训练(post-training) 领域,依然有很多工程方法可以提高模型在特定场景中的表现,尽管这会伴随着指数级的成本上升。以 O3 为例,尽管其性能出色,但高昂的成本却让人对其大规模应用产生了疑虑。不过,考虑到摩尔定律的存在,成本问题在长远来看可能并不成问题。

AGI之路:LLMs是通向未来的关键还是死胡同?

我更为关心的问题是:现阶段以神经网络和 Transformer 架构为核心的 LLMs 是否是我们通向 AGI 的必经之路,还是仅仅是庞大迷宫里的一条死胡同?

从理论上讲,当前技术仍然是基于统计学和概率推理的产物,尚不具备“理解”能力。这意味着,现有的 LLMs 很有可能永远无法达到具备真实理解能力的 AGI。然而,站在现有技术的高度,特别是在像 ChatGPT 这种能够通过摄像头感知世界并与之互动的场景中,我们可以明显感受到其类人水平的智能表现。这使我从感性角度难以接受,这一切仅仅是统计学所能达到的水平。也许我们正处于量变到质变的临界点,突破即将到来。

更重要的是,尽管目前我们对大脑的理解仍不完全,但我们已经无法证伪,真正的“理解能力”是否也可以通过类似 LLMs 的统计学方式实现。换句话说,当前 LLMs 的表现,也许正在逼近理解的边界,甚至已经进入了类似人类认知的阶段。

结语:LLMs—AGI的雏形还是迷途的尼安德特人?

总的来说,当前的 LLMs 是通往 AGI 演化道路上的“尼安德特人”还是“智人”?这个问题充满了不确定性,但无论如何,现阶段的 LLMs 已经在人工智能领域迈出了重要的一步。虽然我们还无法确定这条路究竟能走多远,但毫无疑问,LLMs 将是未来 AGI 发展过程中不可忽视的关键节点。

这个问题值得我们持续关注并深入思考,AGI的进化,或许正如我们探索人类自身的进化过程一样充满着不确定性和惊奇。