[译苑雅集Vol. 29]LLMs会一直改进下去吗?我们对LLMs的期望正确吗?

生成式AI是否会实现完全通用化?如果它无法满足传统计算中的“确定性”期望,我们应该如何调整对AI的期待?本文探讨了生成式AI的独特潜力、错误率背后的机遇,以及它如何重新定义我们的使用方式。同时,文章回顾了技术发展中的期望转变,例如从iPod到iPhone的用户适应过程,为理解生成式AI的未来提供了启示。

作者:Benedict Evans

时间:2025年01月22日

原文:https://www.ben-evans.com/benedictevans/2025/1/the-problem-with-better-models

每周都会有一个新的模型、新的方法或新工具出现。几乎每周都会有人问我:“你试过 O1 Pro 吗?Phi 4 呢?MidJourney 6.1 表现如何?”面对这些问题,我常常思考:我该如何评判呢?

一个直观的答案是查看基准测试的结果,但这些测试的意义究竟有多大,暂且不谈。它们无法告诉我哪些任务是以前无法完成的,或者哪些事情现在可以做得更好。另一种方法是自建一个测试集,比如保存一份包含逻辑难题的文本文件,用来测试新模型的能力。然而,这其实不过是另一种形式的基准测试,对实际工作的启发有限。

更实际的评估方式是将模型直接应用到自己的工作流程中,观察是否真的带来了提升。不过,这里出现了一个问题:对于某些任务,一个更好的模型确实能带来更准确的结果;但对于另一些任务,“更好”或“更准确”并不存在,只有“对”或“错”之分。

事实上,有些问题并没有严格意义上的“错误”答案;输出的质量往往是主观的,“更好”只是一个连续的光谱。例如,MidJourney 从版本 3 到版本 6.1 的进步,是一种逐步优化的“更好”。你可以感受到质量的提升,但这并非是一个明确的对错判断。

而对于某些任务,错误是显而易见且易于修正的。比如,让 ChatGPT 帮忙起草一封电子邮件或提供一些做饭创意。即便模型犯了一些错误,你可以轻松发现并修正它们。

因此,生成式 AI 在两个领域展现了早期且显著的产品市场契合点:软件开发和营销。在这些领域中,错误通常可以通过测试发现,而且很多任务并不存在“错误”的答案。例如,当你让模型为某个新产品或品牌撰写几百字的文案,这种任务很少有绝对的“错误”输出。如果你对产品足够了解,任何不准确的地方都会显而易见。这种情况下,AI 工具依然非常实用。我曾将上一波机器学习浪潮形容为“无限实习生”。如果你有 100 个实习生,可以让他们处理各种任务。尽管他们的工作需要你检查,结果可能参差不齐,但这总比你自己从头做起要高效得多。

然而,还有一类广泛的任务我们希望能够自动化——这些任务既枯燥又耗时,而且无法通过传统软件完成。对于这种任务,结果的质量不是一个百分比,而是一个二元选项。对于某些任务,答案不是“更好”或“更差”,而是“正确”或“不正确”。

如果我需要处理某些答案可能在重要方面完全错误的任务,而我自己又不是该领域的专家,或者没有掌握所有的基础数据,甚至需要重新进行完整验证才能检查其正确性,那么在今天,我根本无法使用大语言模型(LLM)来完成这类任务。

以下是一个我经常做、但希望能自动化完成的实际例子。我问了ChatGPT 4.0一个问题:1980年美国有多少人从事电梯操作员的工作?美国人口普查局收集并发布了这些数据:答案是21,982人(PDF文件的第17页提供了具体数据)。

首先,我直接向模型提问,得到一个具体但没有来源且错误的答案。然后,我尝试提供原始数据源帮助模型,结果得到了另一个错误的答案,同时还附带了一些来源列表,这些来源确实包括美国人口普查局,其中第一个链接指向正确的PDF……但数字仍然是错的。那么我尝试直接提供实际的PDF?不行。告诉它具体在PDF的哪个位置查找?还是不行。让它浏览网络?依然不行,不行,不行……

这里的问题并不仅仅是数字错误,而是我无从得知答案是否正确,除非我自己重新完成所有的工作。它可能是对的。换个提示词,答案可能更接近正确。如果我付费使用Pro版,答案可能更接近正确。但我并不需要一个“可能更接近正确”的答案,尤其是在我无法验证的情况下。我需要一个正确的答案。

当然,这些模型并不提供“正确”答案。它们是概率性的、统计系统,告诉你一个可能看起来不错的答案是什么样的。它们并不是确定性系统,无法告诉你确切的答案。它们并不“知道”或“理解”问题——它们只是近似。“更好”的模型会更接近正确答案,并可能在某些问题类别上表现显著更好,而在其他类别上表现较差(尽管我们可能不知道为什么,甚至不知道类别如何划分)。但这仍然不同于提供一个“正确”的答案——它并不像一个“知道”或“理解”需要在某个PDF中查找1980年这一列和“电梯操作员”这一行的模型。

这种情况在今年或未来十年是否会改变,仍是关于这些模型是否会持续扩展规模以及AGI(通用人工智能)的核心争论之一。目前我们唯一能确定的是,我们缺乏一个可以解释这一切的理论框架。我们不知道。也许随着模型规模的扩展,这种“理解”会自发出现。也许,就像芝诺悖论一样,这些模型永远无法达到目标,但会无限接近正确答案,比如99.99%的正确率,这样一来它们是否“理解”可能也无关紧要了。也许需要一些未知的理论突破。也许OpenAI的O3模型中的“推理”是解决这个问题的一条途径,也可能不是。人们有各种观点,但到目前为止,我们并不知道。而且,就目前来看,“错误率”(如果这甚至是一个合适的表达方式)并不是一个可以通过一些额外工程解决的差距,不像iPhone增加了复制/粘贴功能,或拨号上网被宽带取代。这似乎是这项技术的根本属性。

这引发了几个问题。

从狭义上看,如今大多数使用生成式AI构建公司的创业者,试图通过自动化大公司内部枯燥的后台流程,将生成式AI模型封装为传统确定性软件中的API调用。他们通过工具、流程、控制和用户体验(UX),以及预处理和后处理,来管理错误率(以及我在其他地方多次提到的聊天机器人本身的用户体验差距)。他们将“马套上挽具,戴上眼罩并配上缰绳”,因为这才是获得可预测结果的唯一方法。

然而,随着模型的改进,它们可能会逐渐走向“栈顶”。LLM可以告诉SAP应该运行哪些查询,用户也许可以看到并验证正在发生的事情。但现在是由概率系统控制确定性系统。这可以用来理解所谓的“智能代理系统”(agentic systems),这可能是下一个大趋势,也可能在六个月内被遗忘——LLM将所有其他内容转化为API调用。哪种方式更好?是应该用可预测的系统控制LLM,还是为LLM提供可预测的工具?

这引出了第二组问题。对我的“电梯操作员”问题的有益批评并不是我提示词用得不对,或者我使用了错误版本的错误模型,而是从原则上来说,我试图将一个非确定性系统用于一个确定性任务。我试图将LLM当作SQL来用:LLM并不是SQL,而且在这方面表现得很糟。如果你用Claude尝试我的电梯问题,它会直截了当地告诉你这看起来像是一个具体的信息检索问题,并且很可能出现“幻觉式错误”,然后拒绝尝试。这实际上将一个弱点转化为优势:LLM在判断它是否错误(一个确定性问题)方面表现很差,但在判断它是否可能错误(一个概率性问题)方面表现非常出色。

“颠覆”(Disruption)理论的一部分概念是:重要的新技术通常在那些对上一代技术至关重要的领域表现较差,但它们在其他方面有显著优势。问一个LLM(大语言模型)是否能完成非常具体且精准的信息检索,就像问Apple II能否与大型主机的正常运行时间相媲美,或者问能否在Netscape浏览器中构建Photoshop一样。不,它们确实做不到,但这并不是重点,也不意味着它们没有价值。它们做了其他重要的事情,而这种“其他事情”更重要,并吸引了所有的投资、创新和企业创造。也许,20年后,它们也可以完成那些旧任务——也许最终你可以用PC运行一家银行,或者在浏览器中构建图形软件——但这并不是一开始的重要点。它们解锁了新的可能性。

那么,对于生成式AI来说,那种“其他事情”是什么呢?我们如何以概念性的方式思考那些“错误率是一种特性,而不是缺陷”的领域?

机器学习最初在图像识别领域发挥了作用,但它的意义远不止于此。经过一段时间的探索,人们发现,它真正的本质在于模式识别。同样,你可以花很长时间思考“PC、网络或移动设备的真正意义是什么”。对于生成式AI来说,这种“真正的意义”是什么?我认为现在还没有人真正弄清楚,但把它作为传统软件模式中的一组新的API调用,感觉更像是用新事物来做旧事情。

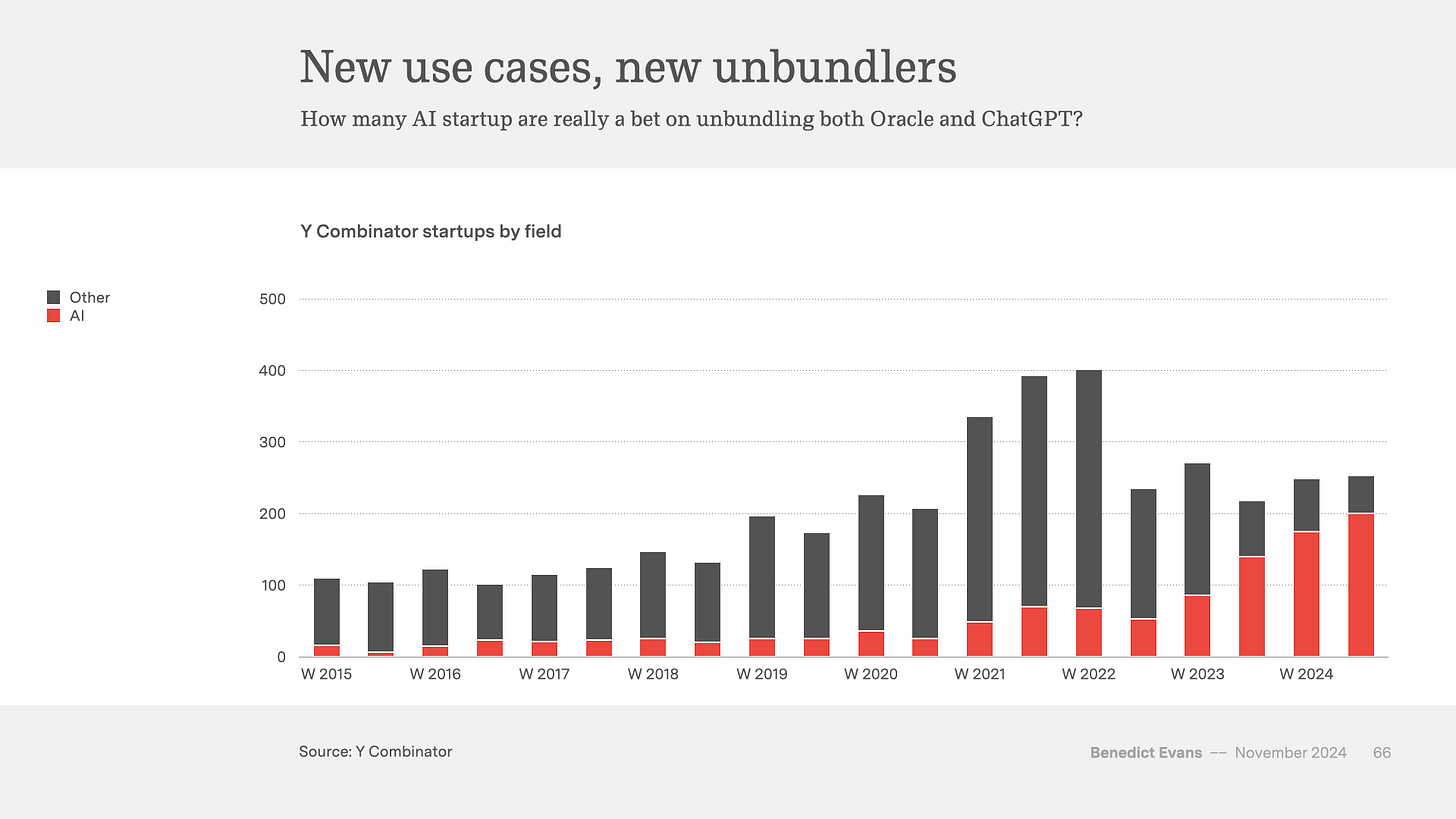

与此同时,有一个老笑话讲到一个法国人说:“在实践中,这一切都很好,但它在理论上可行吗?” 你可能会花太多时间哲学式地思考“这到底意味着什么”,而没有花足够的时间去实际构建和使用它们。以下是一张直观的图表——硅谷的每个人都在用AI构建东西。其中有些会是错误的,有许多会显得无趣,但其中一些会找到真正的新东西。

然而,所有这些公司实际上都在押注于一种哲学:生成式AI不会完全通用化。如果它真的实现了完全通用化,我们就不需要这些各自独立的产品了。

这些问题让我想起了2005年2月,也就是差不多20年前,我在戛纳举办的MWC移动通信大会上与摩托罗拉的一位副总裁的一次会面。当时,iPod是最热门的产品,所有手机OEM厂商都想与之抗衡,但苹果所使用的微型硬盘(micro-HDD)如果设备摔落,几乎肯定会损坏。摩托罗拉的那位副总裁指出,这在某种程度上是期望和感知的问题:如果你摔坏了iPod,你会怪自己;但如果你摔坏了手机,你会责怪手机制造商,即使它使用的是相同的硬件。

六个月后,苹果推出了使用闪存(flash memory)的iPod Nano,而闪存即使摔落也不会损坏。但两年后,苹果开始销售iPhone,而如今你的手机摔落后仍然会损坏,但你很可能会责怪自己。不管怎样,我们接受了一个设备——它摔落后会损坏,电池续航只有一天而不是一周——来换取这种设备带来的某些新东西。我们改变了自己的期望。

这种期望和感知的问题似乎也适用于现在的生成式AI。在经历了50年的消费计算后,我们已经习惯了认为计算机应该是“正确的”——它们应该是可预测的、确定性的系统。这也是我“电梯操作员测试”的前提。但如果你转变这种期望,你会换来什么?