我对DeepSeek和LLM未来的看法

2024 年春节,DeepSeek 的最新模型 V3 和 r1 引发全球热议,其性能已达到 GPT-4 和 Claude 3.5 级别,并凭借出色的工程优化降低了训练和推理成本,使 AI 体验更为普及。与此同时,前沿模型的进展不及预期,LLM 竞赛格局正在发生深刻变化。

各位同仁,新年好! 🎉

整个春节假期都被 DeepSeek 刷屏了,我的 RSS 订阅列表里,有一半的内容都在讨论 DeepSeek,另一半的一半则是关于特朗普的。真是个热闹非凡的假期!

关于 DeepSeek 的几点看法:

V3 已达到 GPT-4 、 Claude 3.5 、Gemini 2.0 和Llama 3 的水平,而 r1 则成为第二个达到 o1 级别的推理模型。

DeepSeek 推出的移动 App 让全球用户都能轻松体验其能力,尤其是 r1 的推理过程可以在 UI 界面中详细展示,极大增强了趣味性,引发的市场反响甚至超越了 O1 推出时的热度。

DeepSeek 在开源方面展现了高度透明度。 从 V3 和 r1 的两篇论文来看,V3 的主要工程创新在于 KV 缓存和 MoE(Mixture of Experts) 的新实现,大幅降低了内存占用和算力需求;而 r1 在V3的基础上,直接采用 强化学习RL(Reinforcement Learning),减少了人工干预SFT(Supervised Fine-Tuning),显著降低了知识蒸馏(distillation)的成本。

这些工程优化不仅降低了训练阶段的计算需求,也大幅减少了推理阶段的性能消耗。 这使得 DeepSeek 能够以极低成本提供 API 服务,同时通过 App 免费提供 r1 模型。

DeepSeek 能赶上 LLM 第一梯队的最关键因素,是前沿模型的进展严重不及预期。 按照一年前的预测,如今 GPT-6 甚至都该发布了,而现实情况是 OpenAI 依旧停留在 GPT-4.5 这一阶段。

在前沿模型停滞不前的情况下,开源模型迎头赶上是自然的结果。 让人意外的并不是这种赶超本身,而是做到这一点的不是 Meta,而是来自中国的 DeepSeek。

与其说这是中国的胜利,不如说是 DeepSeek 这家公司的胜利。 读过《暗涌》对梁文峰的两篇采访就会发现,无论是幻方还是 DeepSeek,它们都不像一家典型的中国公司,甚至不像传统意义上的一家公司。如果将 DeepSeek 换成 OpenAI,我觉得也大有可能是符合OpenAI五年前状况的。

DeepSeek 推出 2C 的 App 的举动,与梁文峰之前介绍的公司发展路线图不完全一致,希望这不是外部压力所致。 我认为梁文峰的思路和战略都非常棒,坚守初心继续往前走,一切才刚刚开始。

关于 LLM 未来的几点思考:

如果短期内 GPT-5(比 GPT-4 强至少 10 倍的 GPT-5而不是单纯把数字加1)能推出,以 DeepSeek 目前能获得的算力,很难迅速追赶。

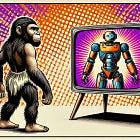

但 GPT-5 很可能出不来了。 LLMs 在 预训练(Pre-training) 方向上可能已经触及天花板,在通往 AGI 的道路上,LLMs 更像是 尼安德特人,而不是 现代智人。

在这种情况下,LLMs 头部公司的数量将从目前的 5 家迅速扩展至几十家,前沿模型迅速同质/大宗商品化commoditization。

推理成本的急剧下降,将推动 LLMs 深入各行各业,并开启对全社会的转型。 相比于继续朝着 AGI 迈进,LLMs 在各种应用场景中的广泛集成,对社会生产力的提升可能更具现实意义。ChatGPT已经是一个不断在加速推出新功能的SaaS产品(最新功能是前几天刚发布的Deep Research)。毕竟,一个特别会聊天的对话框并不是那么有用。

希望中国能涌现出第二家、第三家 DeepSeek,更希望社会和政府能够真正保护 DeepSeek,而最好的保护方式就是“不干预”。

我期望至少半年内不要在媒体上见到梁文峰,如果是一年或者更长会更好,我相信这也是他自己的意愿。