Nvidia 市值飙升:AI 热潮中的赢家

最近,Nvidia 的市值飙升至 3.3 万亿美元,成为全球市值最高的公司。五月下旬,其市值还只有 2.6 万亿美元,市值的暴涨反映了其业务的快速增长。根据2025财年第一季度财报(4 月结束),Nvidia 的季度收入达到了 204 亿美元,其中数据中心业务(即 AI 业务)比上季度增长了 23%,同比增长了 427%。公司毛利率高达 78%,净利率达到了惊人的 57%。6 月 23 日的市盈率(PE,2025年预估)为 48.9 倍。

在历史上,很少有基础硬件厂商的利润率能超过 50%,尤其是在 Nvidia 的营收规模接近 1000 亿美元的情况下。市场的激增吸引了大量投资者,AMD 的 Ryzen 和 Intel 的 Gaudi 正在奋力追赶,主要客户 Alphabet 和微软也在自研 TPU 和 Maia 来阻挡其势头。虽然 AI 仍在热潮高峰期,并且 AI 发展的瓶颈仍受制于算力,但以 IT 行业的过往历史来看,一个技术栈的利润很难长期由底层硬件厂商攫取。

巨头的 AI 战略:微软、谷歌和 AWS 的不同路径

近两个月,从微软的 Build 2024 大会,到 Google 的 I/O 2024 大会,再到最近的苹果 WWDC 2024 大会,几家巨头都发布了各自的 AI 战略。

公有云三巨头 AWS、Azure 和 GCP 借着 AI 的东风,从客户优化成本导致的收入下滑中恢复了过来。然而,在 AI 战略上,三家走出了不同的道路:

微软的 AI 技术栈:底层芯片使用 Nvidia,云服务为自家的 Azure,模型依赖合作伙伴 OpenAI,LLM 平台是 Azure MaaS,应用有自家的 Copilot,同时依赖于第三方应用厂商。

AWS 的 AI 技术栈:芯片也是 Nvidia,云服务为自家的 AWS,模型依赖第三方,LLM 平台是 Bedrock,应用依赖于第三方。

Google 的 AI 技术栈:芯片为自家 TPUs,云服务为自家的 GCP,模型是自家的 Gemini,LLM 平台是 Vertex AI,应用是自己的全家桶。

可以看出,Google 走的是标准的垂直集成路线,整个 AI 技术栈都是自家的,好处是容易控制最终质量。如果未来 LLM 没有商品化,性能和效果长期达不到期望,强集成的技术路线能提供最优的质量。

AWS 则延续了公有云的业务模型,走坚定的 IaaS 和 PaaS 托管路线,不生产内容,赚的就是托管钱。

微软的AI战略最为复杂,这源于其多元化的业务模式。一方面,微软拥有 Azure 的公有云业务,另一方面还包括 Microsoft 365 的 SaaS 业务和 PC 业务。因此,在云端,微软可以被视为 AWS 和 Google 的结合体,不仅通过 Azure 与 Azure MaaS 提供 IaaS 和 AI API 服务,还通过 Copilot AI 功能赋能所有的 SaaS 业务。

Meta 和 AI 开源:社交网络的广告巨头

另外还有 AI 开源领域的最大贡献者 Meta,其核心业务是基于社交网络的广告业务。通过开源 Llama,将与其互补的底层 LLM 算法商品化,最有利于其商业目的,类似于早期 Wintel 联盟致力于将 PC 层商品化。

在 AI 被视为科技大厂生死线的情况下,微软、Google 和 AWS 能选择不同的 AI 战略是非常值得尊敬的。反观国内大厂,都是一个套路……

微软的 Copilot+PC 战略:重振 PC 市场

在 Build 2024 大会前,微软发布了 Copilot+PC 战略,试图一举扭转近几年 PC 不温不火的状态。先是发布了性能标准:40TOPS 以上的 NPU、内存 16GB 以上和 256GB 以上的 SSD。然后携手 Intel、AMD 和高通三套芯片方案,一举发布了几十款 AIPC。在随后的台北 Computex 2024 展会上,几乎成了 AIPC 的新品发布会合集。

在 Copilot+PC 发布会上,微软主要发布了 Recall、Copilot 画图和实时翻译三项 AI 功能,并且提供了 Copilot+Runtime 技术栈,来协助开发者在 PC 上开发 AI 应用,以期继续强化 Windows 的平台地位。

微软计划用在 AIPC 上的模型 Phi-3 的起步版 Phi-3-mini是 38亿参数,Phi-3-small 和 Phi-3-medium 分别是70 亿 和 140 亿参数。

作为 AIPC 旗舰功能的 Recall,虽然预览即拉跨 https://github.com/xaitax/TotalRecall

Windows Recall将数据存储在本地一个未加密的 SQLite 数据库中,屏幕截图也是简单的存放在本地一个文件夹中,你可以在这儿找到它们:

C:\Users\$USER\AppData\Local\CoreAIPlatform.00\UKP\{GUID}图片都存储在下面这个子文件夹中

.\ImageStore\下面是 SQLite 数据库 ukg.db 。

但从战略上看,AIPC 无疑是一着妙棋。与传统软件不同,LLM 每一次推理的边际成本并非趋近于零。通过云端处理,无论是对软件厂商的成本,还是对三大公有云厂商的资本开支,都是巨大的压力。充分利用终端算力,将成本转嫁给最终用户,是一招高明之举。微软对 AIPC 设置标准算力要求,也是为了商品化 AI 边缘算力平台,使软件厂商更容易利用终端算力。

苹果的 Apple Intelligence:用户体验为先

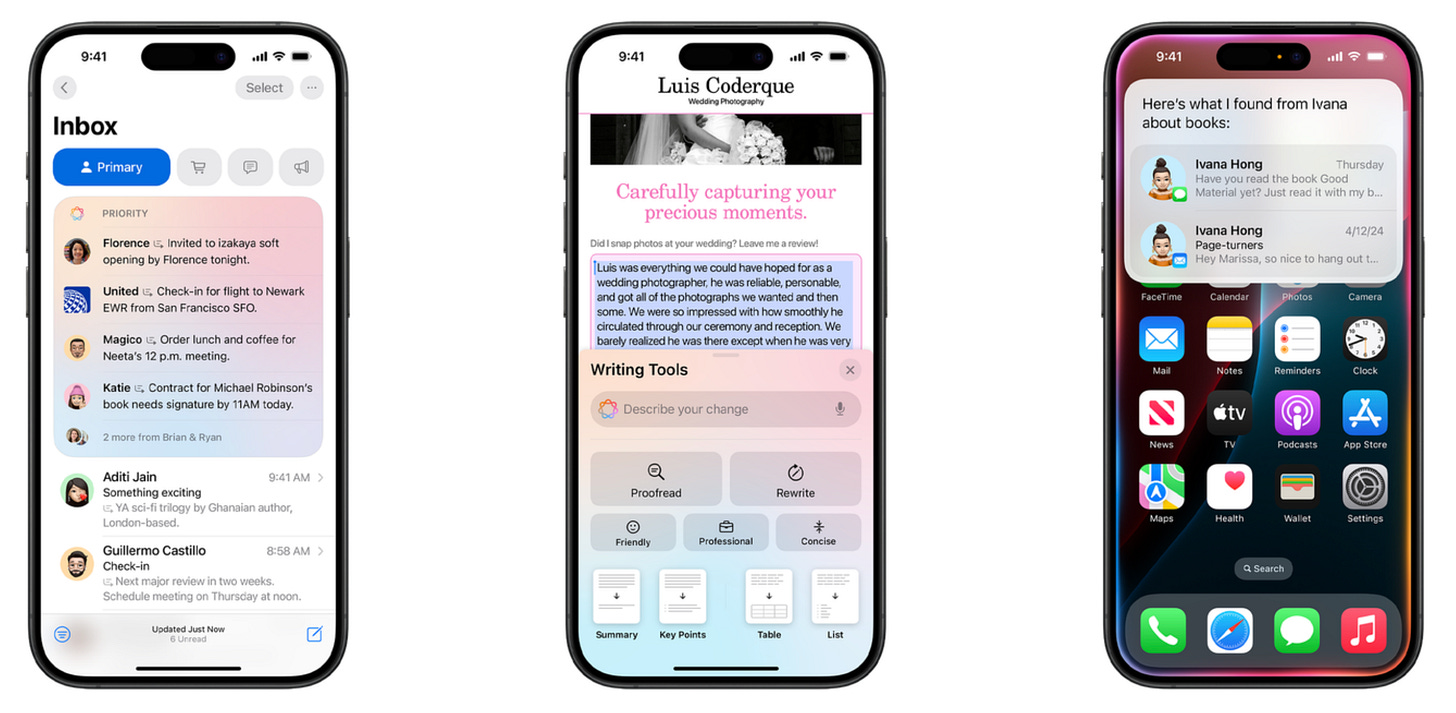

在苹果 WWDC 2024 大会上,苹果如期发布了自己的 AI 战略,非常苹果范的又给起了个不一样的名字 Apple Intelligence。

与聊天形式的 ChatGPT 相反,Apple Intelligence 没有原始的 prompt 输入和结果输出,所有功能都被隐藏在原来的 UI 之下,严格限定了使用场景。体现了苹果用户体验第一的理念,在 LLM 的进展尚不能另人满意的情况下,通过限定场景来提高质量稳定性。

在架构上,终端设备上有两个 LLM,一个处理语言,一个处理文字。文字模型有 30 亿个参数,经过优化,在 iPhone 15 Pro 上 time-to-first-token 时延可以做到 0.6 毫秒,每秒钟能生成 30 个 tokens。本地算力不够时使用云端的 Private Cloud Compute,云端使用与设备上一致的 Apple silicon 硬件,既保证隐私,又提高能源效率。

更多 Apple Intelligence 的信息可以访问苹果的介绍文档 Introducing Apple Foundation Models。

看完 WWDC 的主题演讲,我不禁想起几十年前乔布斯对计算机的比喻。他说:“计算机是人脑的自行车。”而如今,AI 将成为人脑的自动驾驶汽车。

总的来看,微软和苹果的 AI 战略清晰且独特,不服不行。